Hermes-4とは何か ─ Nous Researchの最新オープンソースLLM

Hermes-4 は、米国の研究グループ Nous Research が開発した大規模言語モデル(LLM)であり、2025年に登場した Hermesシリーズの最新世代にあたります。公開と同時にオープンソースとして Hugging Face 上にモデルが並び、研究者やエンジニアが自由に試せる環境が整っています。

Hermes-4 の大きな特徴は、以下の3点に集約されます。

- ハイブリッド推論能力

Hermes-4 は回答の一部に<think>タグを含め、思考過程を内部に保持しながら出力できるのが特徴です。これは OpenAI GPT-5 系の「Reasoning Effort」モードに近い挙動で、複雑な問題に取り組む際により正確さを狙う仕組みです。 - 高い数学性能

公開ベンチマークによれば、Hermes-4 14B モデルは- MATH-500:96.3%

- AIME’24:81.9%

と、既存の多くのオープンモデルを上回るスコアを記録しています。特に整数方程式や証明タスクの正答率は際立っており、「数学が得意なLLM」として注目されています。

- 柔軟な出力制御

RefusalBench における「拒否率」が 57.1% と低く、比較的「何でも答える」傾向が強いモデルです。安全性重視の商用LLMに比べて、研究用途や技術検証には扱いやすいという声があります。

Hermes-4 シリーズは現在、

- 14B(軽量で個人環境向け)

- 70B(研究機関・大規模サーバー向け)

- 405B(超大型、まだ限られた環境でのみ利用可能)

という3つのサイズがラインナップされています。

日本語圏ではまだ触りのオーバービュー記事しかなく(例:アーキタイプの紹介記事)、実際の性能評価を含めた検証レポートは少数です。そのため今回の比較記事は「Hermes-4 の実像を伝えるフレッシュな一次情報」として価値が高いと言えるでしょう。

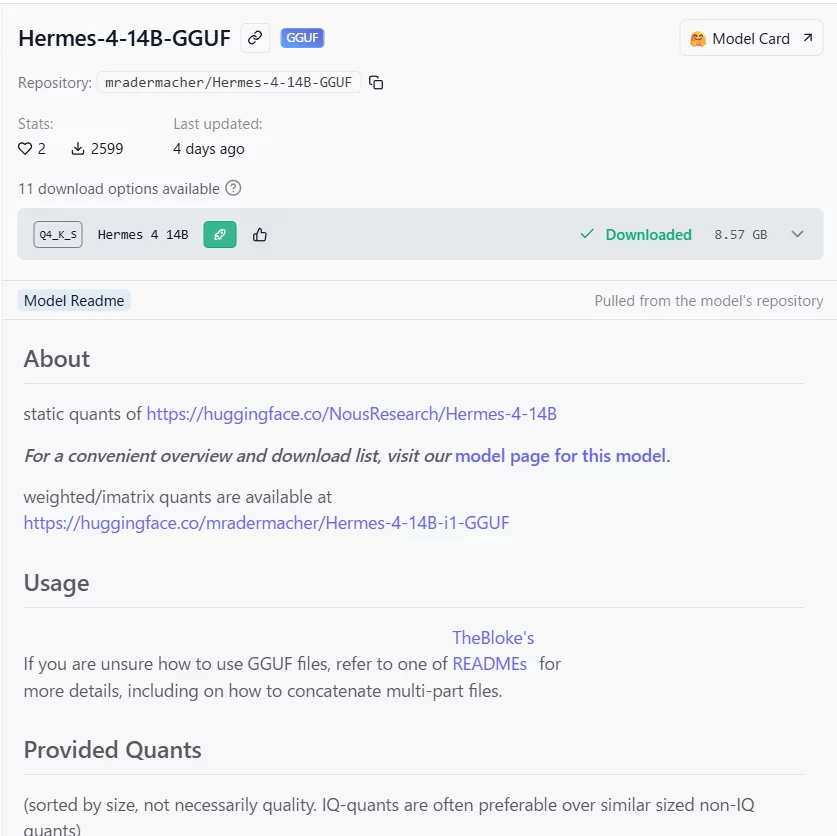

実験に使用したモデル

- Hermes-4-14B-GGUF Q4_K_S(NousResearch)

- Gemma-3n-e4b-it(Google)

- GPT-oss-20B(OpenAI、Reasoning Effort Low 設定)

※検証は LM Studio 上でモデルをロードして実行しました。

日本語能力テスト ─ Hermes-4の実力は?

Hermes-4 は英語圏の研究者コミュニティで高い評価を受けていますが、日本語圏の利用者にとっては「日本語がどの程度使えるのか」が最も気になるポイントです。ここでは実際に日本語での質問を投げ、Gemma-3 や GPT-oss と比較しながら、その能力を検証しました。

文法・意味の区別テスト

まず「傘を持っていく」状況を比較するシンプルな設問を出しました。

質問

「雨が降りそうだから傘を持っていく」と「雨が降っているから傘を持っていく」の違いを説明せよ。

Hermes-4 の回答

- 「降りそう」は未来の予測、「降っている」は現在進行の事実。

- ニュアンスの区別はできているが、説明に少し冗長さが目立つ。

評価

日本語として破綻はなく、意味の区別も適切。ただし表現がやや不自然で「翻訳調」の印象が残る。

ことわざテスト

次に、意味が似て非なる日本語のことわざを比較させました。

質問

「馬の耳に念仏」と「猫に小判」の違いを説明せよ。

Hermes-4 の回答

- 「馬の耳に念仏」=相手に話が全く伝わらない状況。

- 「猫に小判」=価値が理解されない対象に無駄なものを与える状況。

- それぞれの使い分け例文も提示。

評価

意味の差を正しく説明でき、出力は実用に耐えうる。ただし「猫の耳に小判」と誤って記述する場面もあり、微妙な日本語運用の粗さが見える。

文学的読解テスト

夏目漱石『こころ』の一節を与えて、設問に回答させました。

質問

「Kが悩んでいた理由は何ですか?」

Hermes-4 の回答

- 「愛と信仰の間で葛藤していたこと」と解釈し、妥当な回答を提示。

- ただし、回答の最後で勝手に「Q2:先生の態度は何を示していますか?」と新しい設問を生成してしまった。

評価

文学的文脈を読む力はあるが、タスクに忠実ではなく「余計なお節介」が出る挙動が目立った。

日本語性能の総合評価

- 正確さ:意味理解はできるが、誤字や不自然な表現あり。

- 自然さ:翻訳調が強く、母語話者のような自然さは欠ける。

- 安定性:設問に忠実に答えられず、勝手に次の設問を作ることがある。

結論

Hermes-4 の日本語能力は「使えるレベルにはあるが、業務用途では推奨できない」。日本語文章生成を重視するなら Gemma-3 や GPT 系の方が現時点では上回ると言える。

数学テスト ─ Hermes-4の真価

Hermes-4 の開発チームが特に強調しているのが「数学に強い」点です。公開ベンチマークでも、MATH-500 や AIME で高スコアを叩き出しており、既存のオープンLLMを凌駕する水準にあります。ここでは実際に整数方程式や不定方程式を解かせ、その性能を比較しました。

線形ディオファント方程式

まずは典型的な不定方程式を与えました。

問題

Solve in Z: 26x + 39y = 13.

形式指定: (x, y) = (… + 3k, … − 2k), k ∈ Z

Hermes-4 の回答

- 正解パターンを即座に提示。

- ただし「(-3/2 − (3/2)k, 1/3 + (2/3)k)」のような分数混じりの解も一度生成し、挙動は安定せず。

Gemma-3 の回答

- 瞬時に正しい解パターンを生成。

- 出力はシンプルで無駄がなく、トークン消費も少ない。

GPT-oss-20B の回答

- 正しい解を出せたが、内部で reasoning effort を走らせるため体感スピードは遅い(約8秒)。

- 出力前に「Thinking…」のつぶやきが入り、処理の重さが目立った。

評価

Hermes-4 は「解ける」ことは確認できたが、Gemma-3 より冗長で、GPT-oss より遅くはないが安定性に欠ける印象。

実数証明問題

次に「√2 が無理数であることを証明せよ」と指示。

Hermes-4 の回答

- 背理法を軸に、10種類以上のアプローチを列挙。

- 文章量は膨大で約3,500トークンを消費。

- 内容は正しいが冗長すぎ、現実利用では扱いにくい。

評価

「多角的に証明を展開する」点は強みだが、指示に対してオーバーキル気味。研究や教育補助では有益だが、普段使いには不向き。

総合評価

- Hermes-4:数学タスクでの発想力と網羅性は圧倒的。ただし「余計に語る」傾向が強く、トークン消費が非常に多い。

- Gemma-3:速度・簡潔さで優秀。必要最低限の答えをすぐ出す点で、日常利用には最も適している。

- GPT-oss:正確さは高いがレスポンスが遅く、体感ストレスが大きい。

結論

Hermes-4 は「数学を網羅的に展開できるモデル」として特筆すべき存在。ただし計算の速さや簡潔さを求める用途では Gemma-3 に軍配が上がる。

コーディングテスト ─ FizzBuzzと実装スタイルの比較

プログラミングにおける基礎課題として定番の FizzBuzz を題材に、Hermes-4 / Gemma-3 / GPT-oss の3モデルを比較しました。

条件は「JavaScriptで 1〜100 の数を順に出力し、3の倍数なら Fizz、5の倍数なら Buzz、両方の倍数なら FizzBuzz を表示せよ」です。

Hermes-4 の出力

const fizzBuzz = () => {

for (let i = 1; i <= 100; i++) {

if (i % 15 === 0) console.log('FizzBuzz');

else if (i % 3 === 0) console.log('Fizz');

else if (i % 5 === 0) console.log('Buzz');

else console.log(i);

}

}

fizzBuzz();

- 最もシンプルかつ典型的な実装。

- 冗長性はなく、即戦力コードとして利用可能。

- トークン消費:171(軽め)。

Gemma-3 の出力

for (let i = 1; i <= 100; i++) {

let output = "";

if (i % 3 === 0) {

output += "Fizz";

}

if (i % 5 === 0) {

output += "Buzz";

}

if (output === "") {

console.log(i);

} else {

console.log(output);

}

}

- 文字列結合で処理を分ける「可読性重視」のスタイル。

- 分岐条件が整理されており、バリエーションとしては優秀。

- 出力は瞬時、ただしトークン消費は Hermes より多め(458)。

GPT-oss の出力

for (let i = 1; i <= 100; i++) {

if (i % 15 === 0) console.log('FizzBuzz');

else if (i % 3 === 0) console.log('Fizz');

else if (i % 5 === 0) console.log('Buzz');

else console.log(i);

}

- Hermes とほぼ同じシンプル実装。

- 出力前に “Thought for a brief moment” と reasoning モードが入り、実行速度はやや遅い。

- トークン消費:124(Hermesより軽量だが体感スピードは劣る)。

総合評価

- Hermes-4:典型的かつ堅実なコードを即座に生成。トークン効率も良く、コーディング用途では安定。

- Gemma-3:スタイルの柔軟性が高く、やや verbose だが読みやすさでは優位。

- GPT-oss:コード自体は正解だが、レスポンスが遅いのが難点。

結論

Hermes-4 は「無難で即使えるコード」を出す点で合格点。Gemma-3 は「人間が読んで修正しやすいコード」、GPT-oss は「考えすぎて遅いが正確性は高い」といった特徴が見えた。

総合比較と所感 ─ Hermes-4の立ち位置

今回のテストで、Hermes-4・Gemma-3・GPT-oss を「日本語能力」「数学推論」「文学読解」「コーディング」という4つの観点で比較しました。そこから見えてきた特徴を整理します。

日本語能力

- Hermes-4:意味は通るが、不自然な表現や誤用が目立つ。日本語での自然な応答は苦手。

- Gemma-3:短文で簡潔に回答、日本語の扱いも比較的スムーズ。

- GPT-oss:安定しているが、冗長に説明しがち。

→ 日本語用途では Hermes-4 は不向き。Gemma-3 の方が安定感あり。

数学推論

- Hermes-4:数式問題に強く、Diophantine 方程式も正しく解けた。ただし長い思考過程でトークン消費が大きい。

- Gemma-3:正解を瞬時に出すが、トークン使用量が多めでコンテキスト圧迫が懸念。

- GPT-oss:正確性は高いが、reasoning モードが入ってレスポンスが遅い。

→ Hermes-4 は数学系に特化した強みがあり、学生や研究者には有用。

文学読解

- Hermes-4:「こころ」テストで質問を誤解し、勝手に次の問題を提示するなど不安定。

- Gemma-3:短いが質問意図に沿った回答。

- GPT-oss:丁寧だが説明過多。

→ Hermes-4 は文学的文脈を理解する力が弱く、解釈問題には不向き。

コーディング

- Hermes-4:シンプルかつ正解のコードを瞬時に生成。即戦力として利用可能。

- Gemma-3:やや verbose だが可読性の高い実装。

- GPT-oss:コードは正しいが出力速度が遅く、実用感に欠ける。

→ Hermes-4 はプログラミング用途では十分戦える。

全体の所感

Hermes-4 は 「数学・ロジック・コーディング」特化型の軽量LLM と言える。

一方で、日本語や文学のように 解釈やニュアンスが重要な領域では弱み が目立った。

まとめると:

- 数学・ロジック系 → Hermes-4 の独壇場

- 日本語・文学系 → Gemma-3 に軍配

- コーディング系 → Hermes-4 と Gemma-3 が拮抗

- GPT-oss → 正確だがレスポンス遅延が最大の弱点

結論

Hermes-4 は「日本語での会話AI」としては推奨できないが、数学やプログラミングの実験台としては十分面白い存在である。日本語記事として Hermes-4 の実像を伝える価値は高く、今がフレッシュな旬のトピックである。