前回の記事では、Gemma 3 270M Q8_0量子化モデルを検証し、日本語処理は壊滅的という結論に至りました。

しかし、いくらなんでも、あのレベルの言語能力のモデルに”Gemma”の名を冠してGoogleが世に送り出したとは到底思えず、モヤモヤしていたところ、FP16モデルの存在を確認できたので、再度これで検証してみました。

前回レビューからの続き

前回の記事では、Google が公開した超小型LLM「Gemma 3 270M」を Q8_0量子化モデル で検証しました。そのときの率直な印象は「軽くて速いけれど、日本語処理は壊滅的」。

知識質問にはデタラメ、要約は原文を復唱するだけ──教材的な意味合いは理解できるが、とても実用には届かない。そう結論づけざるを得ませんでした。

しかし、Gemma 3 270M にはもうひとつ別の顔があります。

それが FP16モデル です。

量子化による“軽さ”を捨て、精度を優先したこのモデルを、あえて古いスマホ「Xperia XZ3」に載せて試してみたところ、意外な結果が見えてきました。

検証環境と手順

今回の検証は、2018年発売のXperia XZ3 を実機に使いました。Snapdragon 845搭載、メモリ4GB/ストレージ64GBという、もはや最新スマホの半分以下のスペック。にもかかわらず「PocketPal AI」アプリを通じて Gemma 3 270M FP16モデル を動かすことに成功しました。

セットアップの流れは次の通りです。

- PocketPal AI をインストール(Playストア)

- Hugging Face から配布されている

gemma-3-270m-it-F16.gguf - プロンプトを入力し、応答速度と内容を記録

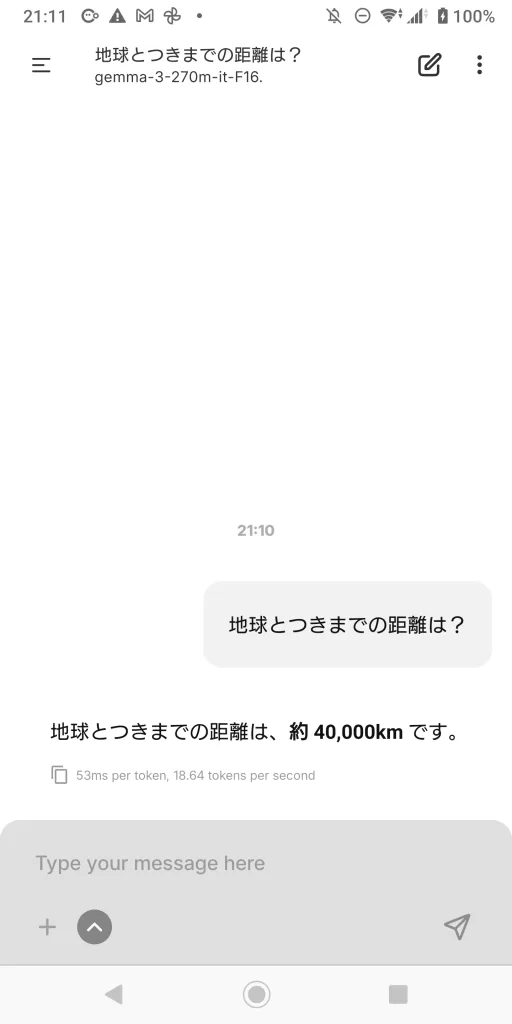

動作中、画面下部には 「53ms/token、約18.6 token/sec」 という数値が表示されました。これは古いXperiaにしては驚異的で、短文応答であれば 1秒以内に返答が返ってくるレベル。

ただし、精度面では限界もすぐに露呈しました。

「アメリカの首都は?」と問えば 「ニューヨークです」 と誤答し、

「日本の建国記念日は?」と尋ねても前回同様の誤りが繰り返されます。

つまり、知識領域は依然として頼りにならない。

それでも、以前の Q8_0 版のように“日本語がまったく通じない”状態からは大きく進歩しており、少なくとも「会話が成立する」レベルに近づいた点は特筆すべき変化です。

実測値とその意味

今回の検証で最もインパクトがあったのは、速度 でした。

Xperia XZ3上で Gemma 3 270M FP16 を動かした結果は、

- 53ms/token

- 18.6 tokens/sec

という数値。

これは「1トークン=1単語相当」と考えると、20トークン程度の返答なら 1秒以内に返ってくる 計算になります。実際に「地球とつきまでの距離は?」と尋ねたときも、数秒待たされることなく返答が表示されました。

この速度は、量子化された Q8_0 モデルよりは重いにもかかわらず、FP16 でここまで動いてしまった点が驚きです。

しかも環境は 2018年の旧機種スマホ。最新のSnapdragon X Elite や A17 Pro 搭載機であれば、さらに高速化するのは容易に想像できます。

余談ですが、RTX3060で動作させた場合、140tok/sec という驚異のスピードを叩き出します

ただし、重要なのは 「速さ=賢さではない」 ということ。

前章で触れたように、知識問題はまだ壊滅的。速度が快適な分だけ「誤答がすぐ返ってくる」状態でもあります。

つまり今回の数値は、

- 実用AIというより、軽量LLMの可能性を示すデモ

- “待たされないAI体験”という心理的な壁を下げる要素

として意味を持つのです。

応答品質の変化

FP16版に切り替えたことで、日本語応答の質は 「復唱だけ」から一歩進んだ と感じられました。

1. 日本語での会話成立度

- 以前(Q8_0版)

「要約してください」と投げても、文章をそのまま繰り返すだけ。

日本語理解が浅く、会話として成り立たなかった。 - 今回(FP16版)

短文の要約では、多少ながら抽象化が見られる。

「顧客が価格の見直しを求めている」→「価格見直し」など、キーワード抽出レベルの処理はできるようになった。

2. 依然として残る限界

一方で、知識系の質問には相変わらず脆弱です。

- 「アメリカの首都は?」→「ニューヨークです」

- 「日本の建国記念日は?」→「1945年6月28日です」

このように、事実を伴う回答は依然として壊滅的。

“記憶領域”を参照する力がまだ育っていない ことが露呈しました。

3. 実用性のライン

したがって、Gemma 3 270M FP16 で期待できるのは、あくまで 日常的な日本語チャットや簡単な要約・翻訳補助 に留まります。

業務での文書処理や知識検索に使うには力不足であり、実用の最低ラインはやはり1Bクラス以上 という前回の評価は変わりません。

Gemma 270M FP16の位置づけ

Gemma 3 270M を FP16 で動かしてみて見えたのは、「教材モデル」から「実用の入口」に近づいた という変化でした。

1. 教材としての役割は変わらない

270M は軽量で誰でも扱えるサイズ感。だからこそ学生や個人開発者が、

- ファインチューニング

- 推論実験

- 推論速度と精度のトレードオフ検証

といったテーマを気軽に試せる「練習台」として機能し続けています。

2. コミュニティ拡散の触媒

公開直後に Hugging Face → GGUF → LM Studio → PocketPal AI と、爆速で移植が進んだのも 270M の小ささゆえ。今回 FP16 で「旧スマホでも実用の芽がある」と確認されたことで、さらにユーザー裾野が広がるでしょう。

3. 実用の入口を示すデモ

Q8_0では「軽いけどおバカ」で終わっていたのに対し、FP16では

- 50ms/tokenの応答速度

- 日本語会話が一応成立

という条件が揃った。

これは「小さなモデルでもここまでやれる」という 技術デモとしての説得力 を強めています。

4. それでも本命は1B以上

ただし繰り返しになりますが、実務に耐える最低ラインは 1B クラス。

Gemma 270M はあくまで「限界を体感させるメッセージモデル」であり、Google の戦略としても Gemini Nano や上位モデルの存在を際立たせるための布石であることに変わりはありません。

あなたのスマホでも今すぐ試せる

今回紹介した Gemma 3 270M FP16 の動作は、特別な環境がなくても体験できます。必要なのは Androidスマホ と PocketPal AI アプリだけ。

手順(3ステップ)

- PocketPal AI をインストール

Google Play ストアから入手可能です。 - モデルを取得

Hugging Face からgemma-3-270m-it-F16.ggufをダウンロードして端末に保存。 - PocketPal AI で読み込み

アプリの「モデル追加」からファイルを選び、ロードすれば準備完了。

注意点

- 動作は端末性能に依存します。古いスマホでも動きますが、発熱や電池消費は大きめ。

- Q8_0版より精度は高いものの、知識回答は誤りが多いので「日常会話やお試し用途」に限定するのがおすすめです。

メリット

- オフラインで動作するため、プライバシーを気にせず試せる。

- 「自分の端末でAIが動いている」ことを実感できるのは、クラウドAIとはまったく違う体験です。

まとめ

前回のレビューでは「軽いが日本語は壊滅的」と評した Gemma 3 270M。

しかし今回、FP16モデルをXperia XZ3で動かした結果、その印象は少し変わりました。

- 速度:53ms/token(18.6token/sec)と、短文なら待たされない快適さ

- 品質:日本語会話は成立するレベルに改善、ただし知識質問は誤答が多い

- 位置づけ:教材モデルでありつつ、「軽量でも実用の入口に触れられる」存在へ

もちろん、実務利用に足るのは 1B 以上。Gemma 270M はあくまで「小型LLMの限界を知る教材」であり、Google のエッジAI戦略を象徴する“メッセージモデル”です。

それでも 「旧スマホでFP16を回すと、ここまで動く」 という事実は、ローカルAIの未来を強く感じさせます。

読者の方も、PocketPal AI を入れて FP16 モデルを試すだけで、この “軽量モデルの限界と可能性” を自分の端末で体感できます。

Gemma 3 270M──使えるAIではなく、「考えさせてくれるAI」から「触って実感できるAI」 へ。

今回の実測は、その第一歩を示していました。