ローカルLLMは「実用インフラ」の段階へ踏み出した

LM Studio が 0.4 系へと進み、すでに 0.4.1 が配信されている。

表面的には細かな修正や機能追加が並ぶアップデートだが、0.4 系全体を俯瞰すると、その意味は決して小さくない。

これは単なるUI改善でも、モデル対応拡張でもない。

ローカルLLMを「業務に置ける存在」に引き上げるための設計変更が、はっきりと見えるアップデートだ。

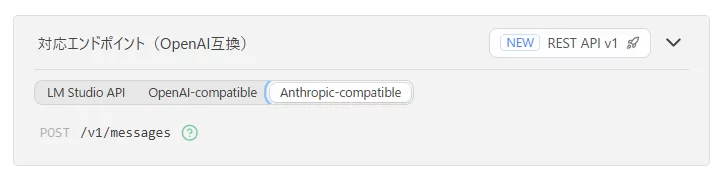

0.4系の本質:API互換は「機能」ではなく「戦略」

0.4.1で追加された /v1/messages エンドポイント。

これは Anthropic API(Claude系)互換を意味する。

重要なのは、「Claudeが使える」という話ではない。

Claude前提で作られたツールチェーンを、そのままローカルLLMに差し替えられるという点だ。

Claude Code をはじめ、近年のAIツールは特定モデルそのものよりも、

「どのAPI仕様を前提に作られているか」に強く依存している。

つまりAPI互換とは、

- モデル選択の自由度

- ベンダーロックイン回避

- 既存ツール資産の再利用

を一気に引き上げる“政治的な一手”でもある。

API互換は思想ではない。

実装された瞬間に、現実の選択肢になる。

LM Studioはこの段階で、「OpenAI互換ローカルサーバー」から一歩踏み出した。

並列処理対応:ローカルLLMが“一人用”を卒業した瞬間

lms load --parallel <N> による並列処理対応。

一見地味だが、実務視点では決定的に重要だ。

これまでのローカルLLMは、

「1リクエストが終わるまで次が待つ」

という構造的な制約を抱えていた。

並列処理が可能になったことで、

- 複数リクエストを同時に受けられる

- ワークフロー型処理が詰まらない

- 外部ツールからAPIとして扱える

という条件が一気に揃った。

これは、LM Studioが

「検証用チャットUI」から「軽量推論サーバー」へ昇格した瞬間でもある。

並列性がないAIは、業務では使えない。

並列性が入った時点で、初めて「運用候補」になる。

lms コマンドの help 表示

※ lms は LM Studio をインストールした環境の OS標準コンソール(PowerShell / Terminal)で実行するCLI

lms --help

Usage: lms [options] [command]

Local models

chat Start an interactive chat with a model

get Search and download local models

load Load a model

unload Unload a model

ls List the models available on disk

ps List the models currently loaded in memory

import Import a model file into LM Studio

Serve

server Commands for managing the local server

log Log incoming and outgoing messages

Runtime

runtime Manage and update the inference runtime

Develop & Publish (Beta)

clone Clone an artifact from LM Studio Hub to a local folder

push Uploads the artifact in the current folder to LM Studio Hub

dev Starts a plugin dev server in the current folder

login Authenticate with LM Studio

logout Log out of LM Studio

whoami Check the current authentication status

Learn more: https://lmstudio.ai/docs/developer

Join our Discord: https://discord.gg/lmstudioresponse_id と MCP:会話AIから“業務フローAI”へ

0.4系では、response_id を用いた会話状態の引き継ぎが可能になった。

これにより、単発の質問応答ではなく、複数ステップにわたる処理が前提となる。

加えて、Model Context Protocol(MCP)への対応。

ローカル環境でのツール呼び出しが、ようやく現実的なものになった。

これは流行り言葉ではない。

- 「質問→回答」で終わるAI

- 「手順を踏む」AI

- 「途中経過を保持する」AI

この差は、業務で使えるかどうかの境界線だ。

OpenAI、Anthropic、Googleが同じ方向を向いている今、

LM Studioもまた、その地層に足を踏み入れたと言える。

そのほか便利になった機能

/v1/responses を通すと、LM Studioは応答ごとに response_id を返す。

これは人間向けの情報ではなく、

複数ステップ処理をつなぐための制御IDだ。

StatusCode : 200

StatusDescription : OK

Content : {

"id": "resp_b40233d7fd04561fd391a2d6dba641900e0a976a4f064a5e",

"object": "response",

"created_at": 1769996313,

"completed_at": 1769996313,

"status": "completed",

"incomplete_details": nu...

RawContent : HTTP/1.1 200 OK

Access-Control-Allow-Origin: *

Access-Control-Allow-Headers: *

Connection: keep-alive

Keep-Alive: timeout=5

Content-Length: 1394

Content-Type: application/json; charset=utf-8

Da...

Forms : {}

Headers : {[Access-Control-Allow-Origin, *], [Access-Control-Allow-Headers, *], [Connection, keep-alive], [Ke

ep-Alive, timeout=5]...}

Images : {}

InputFields : {}

Links : {}

ParsedHtml : mshtml.HTMLDocumentClass

RawContentLength : 1394そのほか強化され、便利になった機能

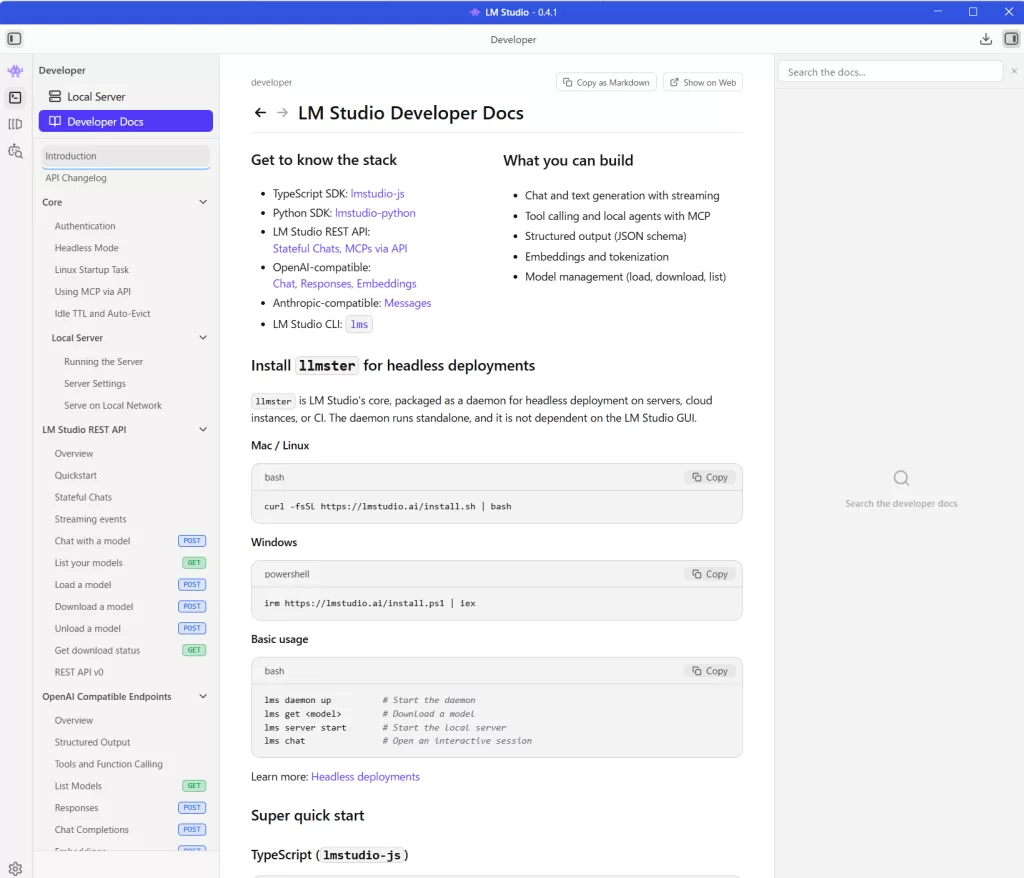

Developerコンソールが賑やかに

APIやMCP、アクセス制御などが前提機能として整理され、

Developerコンソールは「触って試す場所」から「構成を把握する場所」へと変わった。

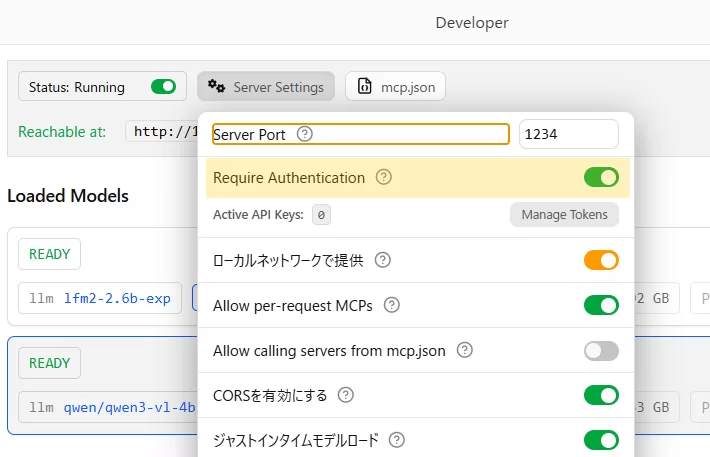

アクセス認証機能

認証設定がモデル単位で切り替えられるようになり、

LM Studioは「全部を一括で守る」段階から「用途ごとに使い分ける」段階へ進んだ。

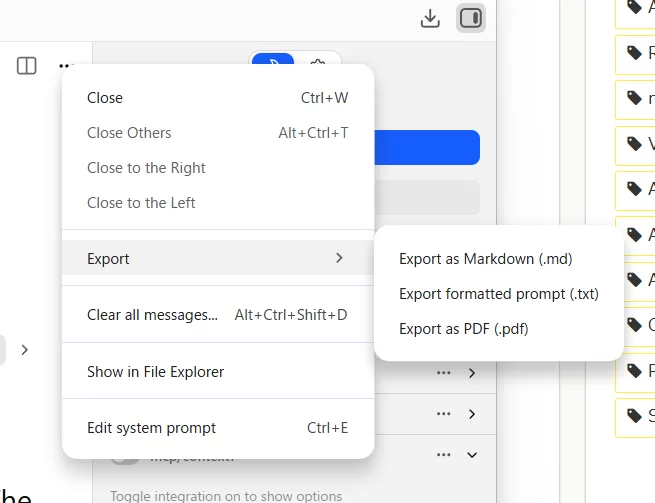

チャットログを markdown や PDF にエクスポートできるようになった

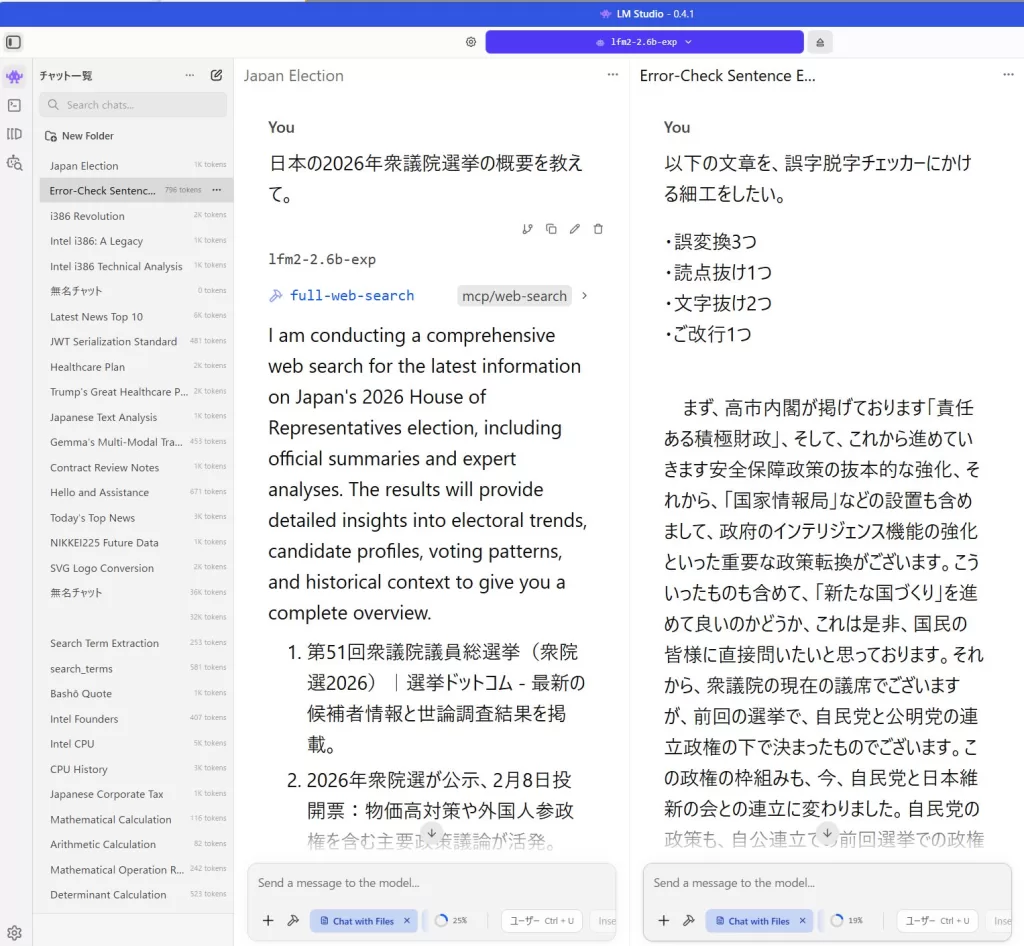

複数チャットを並列表示できるようになった

複数のチャットを並べて表示できるようになり、

LM Studioは「1問ずつ考えるAI」から「同時に比較・検証するAI」へ近づいた。

GUIだけでここまで来た、という異常さ

LM Studioの本当の強みは、ここにある。

- Docker不要

- YAML不要

- Kubernetes不要

- CLI必須ですらない

それでいて、

- API互換

- 並列処理

- MCP対応

- ツール呼び出し

まで揃っている。

これは明確に、中小零细・個人事業・社内IT兼任層を射程に入れた設計だ。

「LLMは使いたいが、インフラ地獄には行きたくない」

その現実的な需要に、最短距離で応えに来ている。

LM Studioは、

“LLMを触れる人”と“LLMを使いたい人”の間にある溝を、GUIだけで埋めようとしている。

これは簡単なようで、極めて珍しい立ち位置だ。

総括:LM Studioは「最速」ではないが「最短」だ

LM Studioは、最先端モデルを最速で試すためのツールではない。

推論性能やモデル規模で競うなら、クラウドLLMや専用ランタイムの方が有利だ。

一方で、「ローカルLLMを実際に使える状態に持っていくまでの距離」という観点では、

LM Studioは他の器よりも明確に短い。

- Ollamaは軽量だが、フロー制御や運用設計は自前になる

- Open WebUIはUIが充実しているが、APIや外部連携は後付けになりがち

- llama.cpp は自由度が高い反面、完成までの実装コストが高い

- クラウドLLMは完成度が高いが、内部は不可視で制御できない

LM Studio 0.4系は、その中間に立つ。

API互換、response_id、MCP、並列処理、認証──

運用に必要な要素を、最小限の設定で一通り揃えた状態で提示してきた。

だからこれは「速さ」の話ではない。

検証から実装、そして運用に入るまでの“最短距離”の話だ。

ローカルLLMを

「触って終わり」にしないための器として、

LM Studioはいま、最も現実的な場所に立っている。