本記事は、「Next AI Drawio を LM Studio と組み合わせて使う」というローカルAI構成が、実用に耐えるかどうかを検証した記録である。

AIに図を描かせる。

それ自体は、もう珍しい話ではない。

だが多くのデモは、クラウド前提だ。

高速で、洗練されていて、確かに気持ちがいい。

一方で、ローカルAIを日常的に使っている身からすると、

どうしても一つの疑問が残る。

これは、ローカルでも使い物になるのか?

結論から書こう。

Next AI Drawio は、ローカルAIでも十分に実用になる。

クラウドとの差が気になるなら、前回の記事を参照して欲しい。

検証環境は「普通」でいい

今回の検証環境は、特別なものではない。

- Docker 上で Next AI Drawio

- LLM サーバー:LM Studio

- モデル:

- gpt-oss

- qwen/qwen3-vl-4b

- Context 長:90k 固定

なお、Next AI Drawio と LM Studio の接続自体は、特別な設定を必要としない。

OpenAI 互換エンドポイントとして LM Studio を指定するだけで動作する。

実際に使用した .env の設定は、以下のような最小構成だ。

AI_PROVIDER=openai

AI_MODEL=lmstudio-model-name

OPENAI_API_KEY=lm-studio

OPENAI_BASE_URL=http://<LM-StudioのIP>:1234/v1

TZ=Asia/Tokyo重要なのは OPENAI_BASE_URL だけで、

それ以外は「OpenAI互換API」として扱うための定型指定に近い。

この設定で、Next AI Drawio 側は特に意識することなく

ローカルの LLM を使った作図が可能になる。

ハードウェアは、いつもの構成だ。

- Pentium G4560

- メモリ 16GB

- ストレージ HDD

正直に言って、最低クラスだと思う。

だが、アプリの読み込みが終わってしまえば使用感に影響はない。

処理の律速は、完全に LLM 側だ。

Next AI Drawio 側は、驚くほど軽い。

公式デモとローカルAIの違い

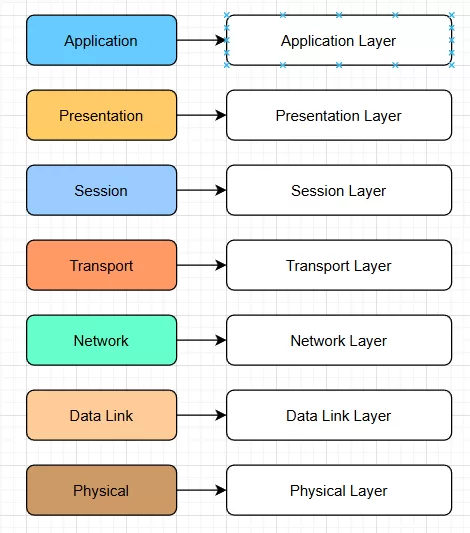

公式デモでは、こうしたプロンプトがそのまま通る。

OSI の 7 layer をカラフルな図解で。キャプション付き。

一行だけで、見栄えのする図が返ってくる。

ここは素直に完成度が高い。

ローカルAIでは、少しだけ気を使う必要がある。

とはいえ、プロンプト職人芸が必要なわけではない。

- 何を図にしたいか

- 図の構造(層・対応関係など)

この二点を意識して書けば十分だ。

「長い指示を書く必要はないが、

丸投げもしない」

その程度の違いでしかない。

今回使用したプロンプト

OSI 7階層参照モデルを、

左に階層(色分けされたボックス)、

右に各層の説明文(短いキャプション)を配置した

カラフルな図解で作成してください。

モデル別の所感

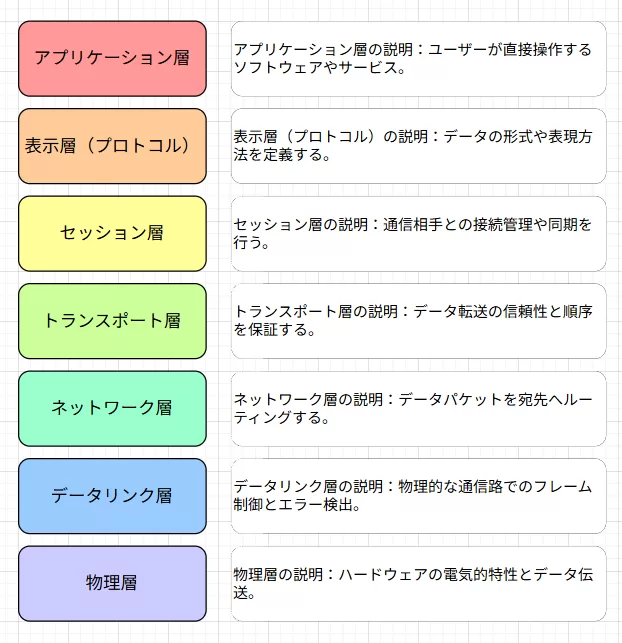

qwen/qwen3-vl-4b

高速に生成され、要素も一通り揃うが、説明や構造がやや冗長になりやすい。

図のたたき台としては十分だが、最終形にするには整理が必要。

生成は速い。

Context を 90k に拡張すると、挙動はかなり安定する。

以前見られたような、

同じ図を延々と繰り返すループ挙動も今回は出なかった。

ただし、図として見るとやや冗長だ。

説明を足そうとする意識が強く、

「止まるべきところで止まらない」傾向は残る。

しかし、4BモデルでVL付きのQwen3がここまでやるのは立派。

gpt-oss

構造が安定しており、過不足のない骨格を一度で出してくる。

派手さはないが、「下書き」として最も手直ししやすい出力。

仕上がりは、明らかにこちらが上だった。

- 図の構造が壊れない

- 色合いもいい

- キャプショニングも優秀

- 教材的な完成感がある

- 一枚描いたところで、ちゃんと止まる

派手さはない。

だが「下書き」としては、非常に使いやすい。

今回の用途では、

gpt-oss のほうが一段上の結果だったと言っていい。

速度は、この用途では主役じゃない

qwen3 のほうが速い。

これは事実だ。

だが AI 作図においては、

数秒の差が体験を大きく左右することはない。

重要なのは、

- 図の骨格が破綻しないこと

- 手直し前提で使えること

- 思考を止めずに次へ進めること

その点で、

速度は決定要因にならなかった。

ローカルAIで使う意味

この構成の価値は、性能ではない。

- クラウドに依存しない

- LAN 内で完結する

- API コストを気にしなくていい

- 思考の途中で、気軽に図を出せる

- 秘密の作図にも使える

完成図を作るためのツールではない。

思考を前に進めるための下書き生成器だ。

Next AI Drawio は、

ローカルAIと組み合わせても、その役割をきちんと果たす。

結論

公式デモの完成度は高い。

それは間違いない。

恐らく、GPT-4oクラスを使用しているのだろう。

だが、

ローカルAIでも「下書き用途」には十分耐える。

派手さより、構造。

速度より、止まれること。

その価値を理解している人にとって、

この組み合わせは、かなり現実的な選択肢になる。

これが今回の実地検証の発見だ。

補章:Next AI Drawio の正体 ― mxGraph XML という中間言語

ここまで読んで、

「Next AI Drawio は便利だが、Docker が少し重たい」

と感じた人もいるかもしれない。

それは正しい感覚だ。

だが、ここで一つ 種明かし をしておこう。

draw.io は、最初から「mxGraph XML」を扱っている

draw.io(diagrams.net)は、

内部的には mxGraph XML という形式で図を管理している。

箱、矢印、接続関係、ラベル。

それらはすべて XML で表現された 構造データ だ。

Next AI Drawio がやっていることは、

この mxGraph XML を LLMに生成させて、draw.io に渡している

それだけと言っていい。

Dockerを使わなくても成立する使い方

ここで発想をひっくり返す。

- Next AI Drawio(Docker)を使う

- 代わりに、Standalone版の draw.io アプリを使う

そして、

- ChatGPTやGemini(あるいはローカルLLM)に

「mxGraph XML を出力して」と頼む - 出てきた XML を

draw.io にインポートする

たったこれだけで、

AI作図の本質的な部分は成立する。

ひと手間は増える。

だが Docker を立ち上げるより、

気楽に感じる人も多いはずだ。

ここで見えてくる、LLMの別の価値

この方法で使ってみると、

一つのことに気づく。

LLMは「描いている」のではない。

構造を言語化しているだけだ。

- レイアウトは draw.io がやる

- 見た目の微調整は人間がやる

- LLMは「骨格」を出す

この分業が成立した瞬間、

モデルの評価軸が変わる。

速さでも、派手さでもない。

構造を壊さずに吐けるか

それだけが価値になる。

「重たいAIツール」からの解放

Docker も Web UI も便利だ。

だが、それが必須だと思い込む必要はない。

- 図はローカルアプリで触りたい

- AIは思考の補助として使いたい

- 下書きが一瞬で出れば十分

そういう人にとっては、

「LLM + mxGraph XML + draw.io」

これだけで、もう完成している。

LLMは、再び「道具」になる

この補章で伝えたいのは、

裏技でも、近道でもない。

LLMは、

派手なUIを通さなくても価値を発揮できる

という、ごく当たり前の事実だ。

Next AI Drawio は、

そのことを分かりやすく可視化したに過ぎない。

道具は増えた。

だが、考える人間の位置は変わっていない。